Analisamos três estratégias para governar o desenvolvimento da Inteligência Artificial Transformadora (TAI): Desenvolvimento Cooperativo (DC), Vantagem Estratégica (VE) e Moratória Global (MG). Avaliamos essas estratégias considerando diferentes níveis de dificuldade de alinhamento e cronogramas de desenvolvimento, focando na prevenção de riscos catastróficos e na promoção do desenvolvimento benéfico da IA.

Nossa análise mostra que a escolha da estratégia ideal muda bastante dependendo da dificuldade de alinhamento e do cronograma. O Desenvolvimento Cooperativo funciona melhor com cronogramas longos e alinhamento fácil, oferecendo flexibilidade e baixo risco. Já a Vantagem Estratégica se torna mais viável em cronogramas curtos ou com dificuldade de alinhamento moderada, principalmente quando a cooperação internacional é difícil, mas carrega um risco maior. A Moratória Global pode ser necessária em cenários com alinhamento muito difícil ou cronogramas extremamente curtos, porém, é a menos viável. O artigo também explora as transições entre estratégias e suas implicações para decisões políticas. Essa análise ajuda formuladores de políticas e stakeholders a avaliarem e adaptarem suas abordagens conforme novas informações sobre alinhamento e cronogramas surgem.

As estratégias de governança da IA são planos que orientam os esforços para influenciar governos ocidentais (Reino Unido, EUA e aliados, por exemplo), grupos subnacionais (como a Califórnia), a comunidade internacional (as cúpulas anuais de segurança da IA) e os principais laboratórios de IA. O objetivo é direcionar os esforços para eliminar riscos existenciais relacionados à IA. Identificamos três estratégias principais que, de certa forma, embasam a maioria das pesquisas e discussões sobre governança de IA.

A eficácia dessas estratégias depende da dificuldade de alinhamento e dos cronogramas da TAI. Exploramos como a força de cada estratégia varia com esses parâmetros. Elas não são mutuamente exclusivas e oferecem diferentes níveis de flexibilidade. Cenários com dificuldade moderada de alinhamento pedem mais investigação.

O debate atual sobre segurança da IA costuma focar em cenários extremos – alinhamento muito fácil ou muito difícil, e cronogramas iminentes ou distantes – ignorando possibilidades intermediárias. Para resolver isso, mapeamos as possibilidades em termos de dificuldade de alinhamento e cronogramas de desenvolvimento da IA. A seção “Comparação de Estratégia” compara as estratégias considerando cronogramas e dificuldade de alinhamento, enquanto “Estratégias Explicadas” analisa cada estratégia em detalhe.

Este trabalho busca ilustrar diferentes visões e destacar áreas que precisam de mais análise. Queremos ajudar indivíduos e organizações a priorizar seu trabalho com uma visão mais completa do cenário estratégico e das principais incertezas. Analisamos três planos principais e como diferentes cronogramas ou dificuldades de alinhamento influenciam sua viabilidade.

As três estratégias (Desenvolvimento Cooperativo, Vantagem Estratégica e Moratória Global) surgiram de uma revisão da literatura sobre governança de IA e conversas com especialistas. Elas se alinham com as “teorias da vitória” da Análise de Convergência.

É importante diferenciar as estratégias desta análise das “teorias da vitória” em outras literaturas sobre governança de IA. Embora possam se alinhar, elas servem a propósitos diferentes e operam em níveis distintos de abstração. As três estratégias apresentadas são abordagens mais concretas e práticas, focando em políticas e ações de curto e médio prazo. Elas oferecem diretrizes sobre o que a comunidade de governança da IA deve fazer agora e nos próximos anos para lidar com os riscos da IA. As teorias da vitória são conceitos abstratos de alto nível, descrevendo estados finais e caminhos amplos para alcançar a segurança existencial contra os riscos da IA. Seu foco é o longo prazo, delineando objetivos finais em vez de ações imediatas. As estratégias podem ser vistas como caminhos para alcançar os objetivos das teorias da vitória, que, por sua vez, fornecem a estrutura para desenvolver e avaliar as estratégias.

Implementar com sucesso qualquer uma dessas estratégias tornaria o mundo mais seguro, mas não garante segurança existencial completa. Elas visam abordar os riscos de conflitos entre grandes potências impulsionados pela IA, mau uso catastrófico e desalinhamento catastrófico da IA, não todos os problemas sociais ou econômicos que a TAI poderia causar. Cada estratégia tem defensores notáveis na comunidade de segurança da IA. Ao analisar essas estratégias amplamente discutidas, buscamos fornecer uma estrutura que capture os principais pontos do pensamento atual na governança da IA, permitindo uma análise diferenciada baseada em dificuldades e cronogramas de alinhamento variados.

A seguir, explicamos como classificamos os resultados ao avaliar as estratégias. Essa estrutura foi criada para ser compatível com diversas visões éticas e políticas e não é uma axiologia específica – funciona melhor como uma lista de heurísticas. Se uma estratégia satisfaz essas heurísticas, provavelmente será benéfica em visões morais comuns. Os primeiros pontos são prioridades essenciais, e os posteriores são etapas subsequentes. Essa abordagem equilibra a prevenção de resultados catastróficos com a preservação do potencial de longo prazo para melhoria. Isso é importante, por exemplo, para mitigar riscos de guerra global, autoritarismo global estável, tomada de controle por IA desalinhada e outros modos de ameaça.

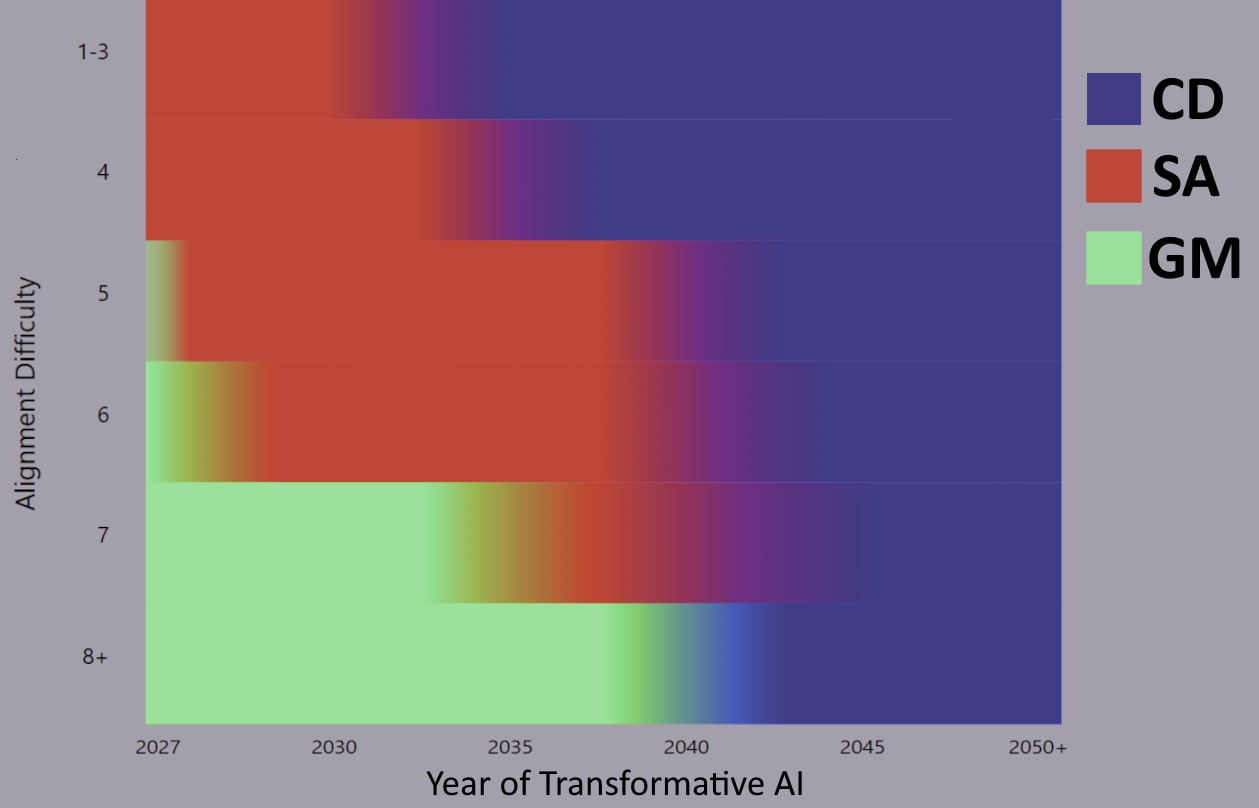

A seguir, uma visão geral de como escolher entre as três estratégias de governança da IA, considerando duas variáveis principais – dificuldade de alinhamento da TAI e cronogramas de desenvolvimento da TAI – que formam a base de nossa tabela de preferência de estratégia, ilustrando como diferentes combinações dessas variáveis influenciam a desejabilidade de cada estratégia. Também exploramos duas variáveis adicionais – velocidade de decolagem da IA e equilíbrio ofensa/defesa da IA. Essa seção dá uma visão geral de como essas considerações devem influenciar nossa escolha entre as três estratégias. Na próxima seção, “Estratégias Explicadas”, faremos uma análise mais ampla e qualitativa, considerando uma gama maior de variáveis.

Duas outras variáveis importantes se correlacionam com a dificuldade de alinhamento e o cronograma da TAI: a velocidade de decolagem da IA (o tempo que leva para um sistema de IA passar de incapaz de automatizar significativamente a economia para a automação total, ou de sub-humano para superinteligente) e o equilíbrio ofensa-defesa da IA (facilidade de causar destruição versus prevenir destruição, dada a ampla disponibilidade da TAI). Esses dois aspectos surgem frequentemente em discussões sobre risco de IA, e por isso são relevantes aqui.

Nossa metodologia se concentra em comparar as estratégias em diferentes cenários, em vez de avaliá-las isoladamente. Isso ajuda a identificar qual estratégia é preferível em diferentes condições e como essas preferências mudam com as circunstâncias. Nossa análise assume que as três estratégias são viáveis em princípio, embora não igualmente fáceis de implementar. Isso permite explorar as implicações de cada estratégia em diferentes cenários de dificuldade de alinhamento e cronogramas de desenvolvimento de IA. Consideramos os cenários em ordem aproximadamente decrescente de viabilidade para promulgar (DC > VE > MG), deixando de lado sua chance de sucesso. “Viabilidade para promulgar” significa a viabilidade da comunidade de governança da IA convencer os atores relevantes a promulgar políticas de acordo com o plano.

Como não descartamos nenhum dos três planos como inviável, ao construir a tabela de preferência de estratégia, fazemos algumas suposições:

Não fazemos suposições sobre cronogramas ou dificuldade de alinhamento de IA, considerando uma ampla gama de curto prazo (~3 anos) a 30+ anos e de muito fácil (alinhamento por padrão) a impossível (qualquer sistema treinado por meio de aprendizado profundo desenvolverá objetivos desalinhados de busca de poder quando escalado para capacidade sobre-humana, independentemente das mitigações aplicadas).

“Curto” significa menos de 5 anos, “médio” de 5 a 20 anos e “longo” mais de 20 anos até a TAI. Nossa análise detalhada da dificuldade de alinhamento explica os níveis de dificuldade, mas brevemente: 1-3 descrevem estados onde técnicas atuais, como RLHF, são suficientes para o alinhamento de intenção da TAI; 4-7 descrevem cenários “moderados” onde sondas de interpretabilidade, supervisão escalável e outras técnicas ainda experimentais são suficientes; e 8-10 descrevem mundos onde abordagens fundamentalmente novas são necessárias para prevenir a busca catastrófica de poder desalinhado, ou o alinhamento da TAI é impossível.

Mapa de calor de preferência de estratégia, considerando cronograma e dificuldade de alinhamento da TAI.

Assumindo que todas as estratégias são viáveis em princípio, este mapa de calor ilustra como a variação no cronograma da TAI e na dificuldade de alinhamento influenciam a escolha da estratégia. O DC é mais preferível quando o alinhamento é fácil e os cronogramas são longos, mas é descartado em cronogramas muito curtos, pois os incentivos para competir são muito fortes. A VE é favorecida para cronogramas curtos e alinhamento mais difícil, e a MG é a única estratégia viável se o alinhamento for muito difícil, a menos que os cronogramas sejam longos. Em cronogramas longos o suficiente, o DC é sempre favorecido, independentemente da dificuldade de alinhamento.

Este mapa de calor assume que, antes de avaliar as variáveis-chave, você é indiferente entre as três estratégias. Essa suposição, embora irreal, ilustra os efeitos da variação do cronograma e da dificuldade de alinhamento isoladamente. Se, por exemplo, você desfavorecer fortemente a VE por acreditar que levará a um conflito global, você ainda deve desfavorecê-la menos em dificuldades de alinhamento mais baixas e cronogramas mais curtos.

Comparação de Estratégia

Examinamos como a dificuldade de alinhamento e o cronograma de IA influenciam a escolha da estratégia. Nesta seção, faremos uma exploração qualitativa de DC, VE e MG. Para cada estratégia, analisaremos suas suposições subjacentes, mecanismos operacionais e resultados potenciais. Argumentaremos que cada estratégia, apesar de seus desafios, é viável em princípio e poderia ser a ideal dependendo do desenrolar dos eventos.

Consideraremos diversos fatores, incluindo dinâmicas geopolíticas, o equilíbrio ofensa-defesa nas capacidades de IA, o potencial para cooperação internacional e o papel de várias partes interessadas no desenvolvimento de IA. Ao examinar essas estratégias por meio de múltiplas lentes, pretendemos fornecer uma compreensão diferenciada de cada abordagem, destacando seus pontos fortes e potenciais fraquezas. Embora nossa tabela de preferência de estratégia se concentre na dificuldade de alinhamento e nos cronogramas, nossa análise mais ampla considera vários parâmetros estratégicos:

Estratégias Explicadas

Desenvolvimento Cooperativo (DC)

A ideia por trás do Desenvolvimento Cooperativo é a aceleração defensiva ou o desenvolvimento tecnológico diferencial, conduzido cooperativamente entre vários atores sem a intenção de criar um “singleton” (uma única hiperpotência de IA com vantagem estratégica). O DC reconhece que o progresso da IA sozinho não garante segurança, mas acredita que tecnologias de proteção podem ser desenvolvidas por meio de iniciativa privada, parcerias público-privadas ou envolvimento limitado do Estado – sem controle estatal completo. Não se trata de uma corrida, mas de antecipar desenvolvimentos e criar regulamentações e tecnologias defensivas eficazes. A agressividade e os atores envolvidos variam de acordo com os detalhes do plano: para alguns, a “nacionalização branda”, com alguns desenvolvedores favorecidos cooperando estreitamente com o governo, é o ideal; para outros, pode ser mais amplo, focando em responsabilidade e transparência.

Três exemplos dessa visão vêm de Carl Shulman, Vitalik Buterin e Holden Karnofsky. Nos planos de DC, geralmente há um componente internacional, talvez envolvendo suporte à decisão de IA ou previsão, para neutralizar conflitos potenciais e evitar corridas, mesmo com progresso rápido. O DC é cauteloso com a aceleração do progresso no desenvolvimento de capacidades de IA em geral (por exemplo, por meio de construções dramáticas de infraestrutura de computação prematuramente) e só a favoreceria se isso acelerasse diferencialmente as tecnologias defensivas o suficiente para justificar o cronograma de IA perdido.

As estratégias de Desenvolvimento Cooperativo têm várias características principais. Em vez de impedir permanentemente a difusão de tecnologias de IA perigosas, o DC se concentra em maximizar o intervalo de tempo entre desenvolvedores responsáveis e irresponsáveis. Se implementado com sucesso, o DC tem recursos desejáveis. No entanto, ele se baseia em suposições cruciais que, se violadas, poderiam torná-lo inviável.

Análise do Desenvolvimento Cooperativo

O Desenvolvimento Cooperativo é uma estratégia “business as usual” evoluída que tenta usar mecanismos normais de adoção e adaptação de tecnologia para lidar com o desafio da TAI. O objetivo é implantar sistemas de IA alinhados e poderosos para fins defensivos antes que a IA desalinhada ou mal utilizada se torne uma ameaça significativa. Mesmo que as capacidades perigosas da IA eventualmente se difundam (o que o DC assume que provavelmente acontecerá, já que não depende do controle do governo para interromper completamente a proliferação da IA), esse “tempo de espera” é crítico para reduzir o risco geral representado pela TAI.

As ações de proteção tomadas pelos projetos líderes são necessárias para aprimorar o alinhamento, fornecer defesa física contra novas ameaças, defender contra ataques cibernéticos e melhorar a cooperação. Essas capacidades podem incluir pesquisa de alinhamento automatizada, novas tecnologias de armas defensivas, contra-ataques a vírus (biodefesa automatizada), ciberdefesa aprimorada e ferramentas de suporte à decisão e previsão de IA.

O DC também favorece a manutenção do controle humano central sobre a tomada de decisões, ou um “humano no circuito” pelo maior tempo possível. A eficácia do Desenvolvimento Cooperativo é altamente dependente da dificuldade de alinhamento e dos cronogramas de desenvolvimento da IA. Em cenários de alinhamento fácil (níveis 1-4), o DC torna-se cada vez mais viável, pois podemos antecipar uma ampla disponibilidade de sistemas TAI relativamente confiáveis e poderosos para fins defensivos, juntamente com uma menor frequência de sistemas desalinhados, o que significa que a aceleração defensiva crucial para o DC torna-se mais viável.

Em relação à velocidade de decolagem, o DC é mais eficaz em cenários com decolagens mais lentas e graduais. Isso dá tempo para que as estruturas regulatórias amadureçam, a cooperação internacional se solidifique e as tecnologias defensivas sejam amplamente adotadas. Decolagens mais lentas também reduzem o risco de um único ator obter uma vantagem estratégica decisiva, o que é essencial para manter a natureza cooperativa dessa abordagem. O DC pode ter sucesso em decolagens mais rápidas, especialmente com a ajuda do suporte à decisão de IA para navegar na transição, mas é mais perigoso tentar.

Para que o DC tenha sucesso, é necessário que haja tempo suficiente desde o desenvolvimento da TAI alinhada com a intenção para que ela se propague amplamente e seja usada de maneiras que melhorem as defesas do mundo contra sistemas de IA desalinhados. No entanto, à medida que a dificuldade de alinhamento aumenta ou os cronogramas encurtam, o DC enfrenta maiores desafios. Cenários de dificuldade de alinhamento médio apresentam desafios de governança mais complexos, mudando o foco para a criação de instituições capazes de responder rapidamente a evidências ambíguas de desalinhamento. Nesses casos, todos os desenvolvedores de IA de fronteira precisam cultivar uma forte cultura de segurança para que o DC permaneça viável, e é provável que seja necessária mais intervenção do governo, por exemplo, por meio de parceria público-privada. Cronogramas mais curtos aumentam a pressão sobre o DC, pois há menos tempo para aceleração defensiva por meio de canais cooperativos. Isso pode exigir uma mudança para estratégias mais agressivas.

A viabilidade do DC também depende fortemente da extensão da cooperação internacional, que se torna cada vez mais vital à medida que as velocidades de decolagem aceleram e a velocidade relativa de difusão da tecnologia de IA diminui. Sem coordenação global adequada, os esforços nacionais de DC poderiam se transformar em cenários de Vantagem Estratégica (VE) de fato, especialmente se todos os principais projetos de IA estiverem concentrados em um único país, como os EUA. Isso se torna mais provável se as tecnologias TAI desenvolvidas por meio de parcerias público-privadas acabarem sob controle do governo. A probabilidade de conflito também depende da taxa de disseminação natural da tecnologia de IA.

Se a tecnologia TAI se difundir facilmente, de modo que o “crescimento de recuperação” seja sempre possível, pode não haver um único estado com uma forte vantagem estratégica, e os mecanismos usuais de dissuasão poderiam impedir o conflito sem acordos internacionais fortes. No entanto, se a velocidade de difusão da tecnologia for lenta em relação à velocidade de decolagem da IA, pode haver lacunas substanciais entre os principais projetos de TAI. Isso pode resultar em fortes pressões para competir ou correr, levando ao surgimento de uma dinâmica do tipo “o vencedor leva tudo”. Neste cenário, os acordos internacionais tornam-se mais necessários.

Os sistemas de suporte à decisão alimentados por IA podem desempenhar um papel fundamental na facilitação do DC, fornecendo informações claras e verificáveis para auxiliar na tomada de decisões e reduzir a escalada de potenciais corridas armamentistas durante o período de rápida mudança de decolagem da IA. Para que esses sistemas surjam a tempo, a fase crítica de decolagem da IA não deve ultrapassar a capacidade de adaptação da sociedade, ou deve haver uma difusão suave da tecnologia de IA. Cronogramas mais longos são mais propícios ao DC, pois permitem mais oportunidades para que as tecnologias defensivas e a cooperação internacional amadureçam. Cronogramas mais longos estão correlacionados com decolagem mais lenta, reduzindo a probabilidade de uma vantagem estratégica decisiva e, portanto, reduzindo a necessidade de acordos internacionais fortemente vinculativos para garantir que um projeto não avance na corrida.

Regulamentações rígidas podem ser necessárias para o DC, mesmo sem a nacionalização total do desenvolvimento da IA. A extensão da regulamentação necessária depende de fatores como dificuldade de alinhamento, equilíbrio ofensa-defesa, número de maus atores e situação geopolítica. As regulamentações podem incluir requisitos de transparência, avaliações de terceiros e medidas para garantir o desenvolvimento proativo de tecnologias defensivas. Se a situação for favorável de várias maneiras, com desenvolvedores responsáveis e decolagem mais lenta, os requisitos de responsabilidade, os compromissos voluntários e nenhum desenvolvimento proativo podem ser suficientes.

Muitos céticos em relação à regulamentação ou cientes de casos passados de falha regulatória ou captura regulatória argumentariam que as abordagens de DC não resultariam em regulamentações vinculativas que abordam efetivamente os riscos catastróficos e, em vez disso, resultariam apenas em requisitos inúteis e onerosos que retardam os atores cumpridores da lei enquanto não fazem nada sobre os riscos, ou até mesmo produzem falsa segurança. Eles também podem apontar para as dificuldades de medir o progresso do alinhamento para argumentar que as regulamentações de IA imporão encargos aos desenvolvedores cautelosos, sem abordar as preocupações reais de alinhamento. Eles podem argumentar ainda que é impossível chegar a um acordo de boa-fé com adversários como a China e tentar apenas abrir a porta para uma desvantagem estratégica, mesmo que tais regulamentações sejam bem-sucedidas nos países ocidentais.

Outra objeção é que o DC depende muito da suposição de que os principais laboratórios de IA são preocupados com a segurança. Se alguém acredita que esses laboratórios não estão genuinamente comprometidos com a segurança ou estão dispostos a cortar custos e se envolver em práticas antiéticas para obter vantagem competitiva, isso prejudica a viabilidade do DC. Alguns também podem argumentar que o DC também não ajuda a mitigar os incentivos para projetos militares criarem modelos perigosos e não civis.

Os proponentes do DC têm várias maneiras de responder a essas objeções. Uma resposta importante é que, embora existam desafios regulatórios, existem exemplos de regulamentação internacional bem-sucedida em domínios de alto risco, da não proliferação nuclear à segurança da aviação. Com vontade política suficiente e evidências claras dos riscos da IA, regulamentações eficazes poderiam ser implementadas, e já vimos exemplos de inovação regulatória (por exemplo, na AISI do Reino Unido) voltados para modelos de ameaças ainda hipotéticas, como alinhamento enganoso.

Sobre a cooperação internacional, os defensores do DC apontam para casos em que os países colaboraram com sucesso em desafios globais, como acordos sobre mudanças climáticas, e os sinais promissores de que as preocupações com o risco da IA já estão sendo levadas a sério globalmente. Quanto à mentalidade de segurança do laboratório de IA, os proponentes sugerem que uma combinação de pressão pública, incentivos de mercado e supervisão regulatória poderia alinhar efetivamente o comportamento do laboratório com as metas de segurança sem a necessidade de fortes suposições sobre a cultura de segurança. Eles também argumentam que o DC não depende necessariamente da confiança completa nos laboratórios de IA, mas sim da criação de uma estrutura que incentive e aplique práticas de desenvolvimento seguras.

No geral, embora (como todas as estratégias) o DC enfrente desafios formidáveis, ele representa talvez a evolução mais natural dos esforços atuais de governança da IA. Dadas certas suposições plausíveis sobre a cooperação internacional e o desenvolvimento de tecnologias defensivas, ele oferece um caminho viável para o futuro que se baseia em estruturas institucionais existentes, em vez de exigir mudanças radicais. A maior força do DC reside em sua flexibilidade e sua capacidade de manter o desenvolvimento benéfico da IA enquanto trabalha dentro das normas estabelecidas. Ao se concentrar no desenvolvimento com defesa em primeiro lugar e manter a transparência internacional, ele poderia criar uma base estável para gerenciar os riscos da TAI por meio da cooperação, em vez da competição. A ênfase da estratégia na defesa distribuída e em vários sistemas alinhados independentes fornece redundância crucial contra pontos únicos de falha. Embora o DC exija coordenação internacional significativa e possa ter dificuldades com o desenvolvimento muito rápido da IA, seu alinhamento com as tendências atuais de governança e sua capacidade de transição para outras estratégias, se necessário, o tornam uma estratégia de governança da IA importante e viável.

Vantagem Estratégica (VE)

A Vantagem Estratégica parte da premissa de que as abordagens cooperativas são insuficientes e que é necessário um controle mais agressivo sobre o desenvolvimento da IA. Talvez as tecnologias de IA sejam intrinsecamente dominantes na ofensiva e muito perigosas para manter sob controle, de modo que, mesmo que existam tecnologias de proteção desenvolvidas com antecedência, as capacidades perigosas da IA ainda se difundirão muito rapidamente. Nessa visão, planejar que as capacidades perigosas da IA eventualmente se difundam e esperar que possamos lidar com elas quando isso acontecer é planejar o fracasso. Portanto, apenas poucas empresas estritamente nacionalizadas ou em estreita cooperação com um governo poderiam resolver o alinhamento e construir as tecnologias de IA defensivas necessárias.

A VE também é motivada pela visão de que a competição internacional é inevitável: a atual situação geopolítica, combinada com a extrema vantagem proporcionada pelas tecnologias TAI, torna inviáveis quaisquer tentativas de cooperação internacional, conforme descrito no DC. Por qualquer um ou todos esses motivos, os proponentes da VE argumentam que o DC é inviável e, portanto, a única opção restante é vencer a corrida da IA.

O plano de Vantagem Estratégica propõe que uma nação ou uma pequena coalizão de nações deve ter como objetivo ser a primeira a desenvolver sistemas de IA avançados e alinhados. Essa abordagem combina elementos do conceito de Leviatã de IA, onde uma única entidade controla a IA, com uma forte ênfase em garantir que a IA esteja alinhada com os valores humanos e que seus supervisores sejam responsabilizados. Para alcançar essa vantagem, o plano sugere investimentos significativos em pesquisa e desenvolvimento de IA, incluindo a construção de infraestrutura de computação massiva, atraindo os melhores talentos de IA para um país ou uma aliança próxima (geralmente os EUA e aliados) e potencialmente até mesmo empregando táticas agressivas como controles de exportação ou operações cibernéticas contra adversários, para manter a liderança na corrida TAI.

Moratória Global (MG)

A Moratória Global (MG) propõe uma pausa temporária no desenvolvimento de sistemas de IA avançados, com o objetivo de desenvolver melhores mecanismos de segurança e alinhamento antes de prosseguir. Proponentes da MG argumentam que o ritmo atual de desenvolvimento da IA é muito rápido, e que os riscos de desalinhamento e mau uso são muito altos para continuar sem uma pausa estratégica. Uma moratória permitiria um tempo para pesquisa em segurança de IA, desenvolvimento de padrões e regulamentações internacionais, e discussão pública sobre as implicações éticas e sociais da IA.

A implementação de uma MG enfrenta desafios significativos. Obter um acordo global entre nações com diferentes interesses e níveis de desenvolvimento tecnológico seria extremamente difícil. Além disso, uma moratória poderia prejudicar a inovação e o desenvolvimento econômico, e alguns países poderiam optar por ignorar a moratória, obtendo uma vantagem estratégica. Apesar desses desafios, os proponentes da MG argumentam que os riscos potenciais de uma IA não alinhada superam os riscos de uma moratória temporária. Eles sugerem que uma moratória bem estruturada, com exceções para certas áreas de pesquisa e desenvolvimento que não representem riscos imediatos, poderia ser uma forma eficaz de mitigar riscos existenciais. A duração e a abrangência da moratória seriam pontos cruciais de negociação, que precisariam ser cuidadosamente definidos para equilibrar a necessidade de segurança com a necessidade de inovação contínua. Uma MG poderia ser vista como um caminho para um DC, onde um tempo de pausa coletiva daria espaço para acordos e cooperação internacional, mitigando o risco de uma corrida armamentista de IA. A grande incerteza aqui é se uma MG poderia realmente ser implementada globalmente, e quanto tempo levaria. Caso não possa ser implementada globalmente, corre-se o risco de o desenvolvimento continuar e uma corrida armamentista ainda pior começar.

Aqui na Wonder Academy, estamos sempre buscando as melhores formas de preparar profissionais para o futuro. A complexidade da IA transformadora exige uma abordagem estratégica e colaborativa, e este artigo busca contribuir para esse diálogo essencial. Para aprofundar seus conhecimentos sobre o assunto, acesse Wonder Academy e explore nossos cursos.